#后门缓解

Article

Zhang, Xiaoyu, Yulin Jin, Tao Wang, Jian Lou和Xiaofeng Chen. 《Purifier: Plug-and-Play Backdoor Mitigation for Pre-Trained Models Via Anomaly Activation Suppression》. 收入 Proceedings of the 30th ACM International Conference on Multimedia, 4291–99. Lisboa Portugal: ACM, 2022. https://doi.org/10.1145/3503161.3548065.

Data

背景:

- fine-tuning和fine-pruning在干净数据下准确率下降

- MCR(Mode Connectivity Repair)通过小部分干净样本的训练路径可以显著修复模型的后门连接通路,显著强于ft和fp算法。

- NAD(Neural Attention distillation蒸馏),ABL(Anti-Backdoor learning)对于微调过程过于复杂化。

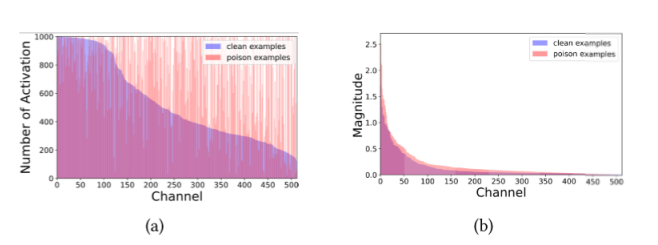

目前主流的防御都在模型的输入端和输出端进行研究,但对中间层缺少深入探究,在逃脱攻击中的对抗性例子中,可以发现中间层的通道激活的不同分布和幅度,由此提出抑制异常激活,来抵抗攻击。

该论文(Han Qiu, Yi Zeng, Shangwei Guo, Tianwei Zhang, Meikang Qiu, and Bhavani Thuraisingham. Deepsweep: An evaluation framework for mitigating dnn backdoor attacks using data augmentation)提到后门攻击和对抗性示例有显著区别:对抗攻击主要是采用Lp范数作为对抗性扰动,如L2扰动范围内的对抗示例扰动大小被限制为不超过一定值,这通常被表示为“L2扰动大小小于epsilon”

Different from Adversarial Examples (AE) where the adversarial perturbation is strictly bounded, a backdoor attacker can inject a trigger with an arbitrary size, location, and content to the samples.

方法:

三种细粒度不同的净化器方法:首先从不同粒度来平均特征,然后用一个简单的辅助分类器来分类,通过干净数据的标签来生成Mask掩码,与预训练模型的最后一个卷积层输出张量相乘,以此来抑制后门label的特征值。

- 通道层面,将特征图

[l*w*h]每个通道的特征(宽高)使用平均池化操作 - 立方体层面,将特征图分成若干个立方体

- 特征层面,通过划分水平和垂直等特征,将特征图分成若干个特征

结果:

新的度量:\frac{1-ASR}{Epoch},表示防御成功率与指定任务协同训练的效率,值越高,效率越高

三种净化器模块均表现出满意的ASR、ACC、效率和稳定性,但通道模块和特征模块在所有测量方面都略优于立方体模块

Comment

问:在该问题中channels不是指RGB的通道数,因为图片中出现了500,难道是神经元?(已解决)

答:通过学习典型的卷积神经网络Lenet和Resnet,我了解到卷积神经网络通常会缩小尺寸,增大通道数。缩小尺寸通过设定步长或采用池化层,目的是减少内存占用和计算量;增大通道数通过设定多个卷积核并行处理,每个通道的值可以看作是一个特征,作用是提高模型的表达能力和泛化能力。综上,channels增大到500多是合理的。

问:本文解决问题的主要启发在于下图中,后门模型的通道激活的分布更均匀,表明许多冗余通道对下一层有更多的变化。这有些不符合我对后门触发的理解,我觉得像BadNets,应该只有部分通道被明显触发,其他都是权重比较低的?

Notes

pre-trained models (PTMs)

优秀的后门缓解机制满足需要三大要求:

- 对各种不同触发属性的后门攻击有全面的防御能力

- 对后门攻击没有任何的先验知识

- 足够灵活,适用于不同的预训练模型,尽可能少地干扰微调过程